企业正在加速采用 AI 技术

全组织部署 AI 应用与智能体时,常因安全措施缺失

而引发新型风险。

拼凑式单点解决方案难以应对 AI 安全防护的挑战。

您需要覆盖 AI 全生命周期的端到端安全保障

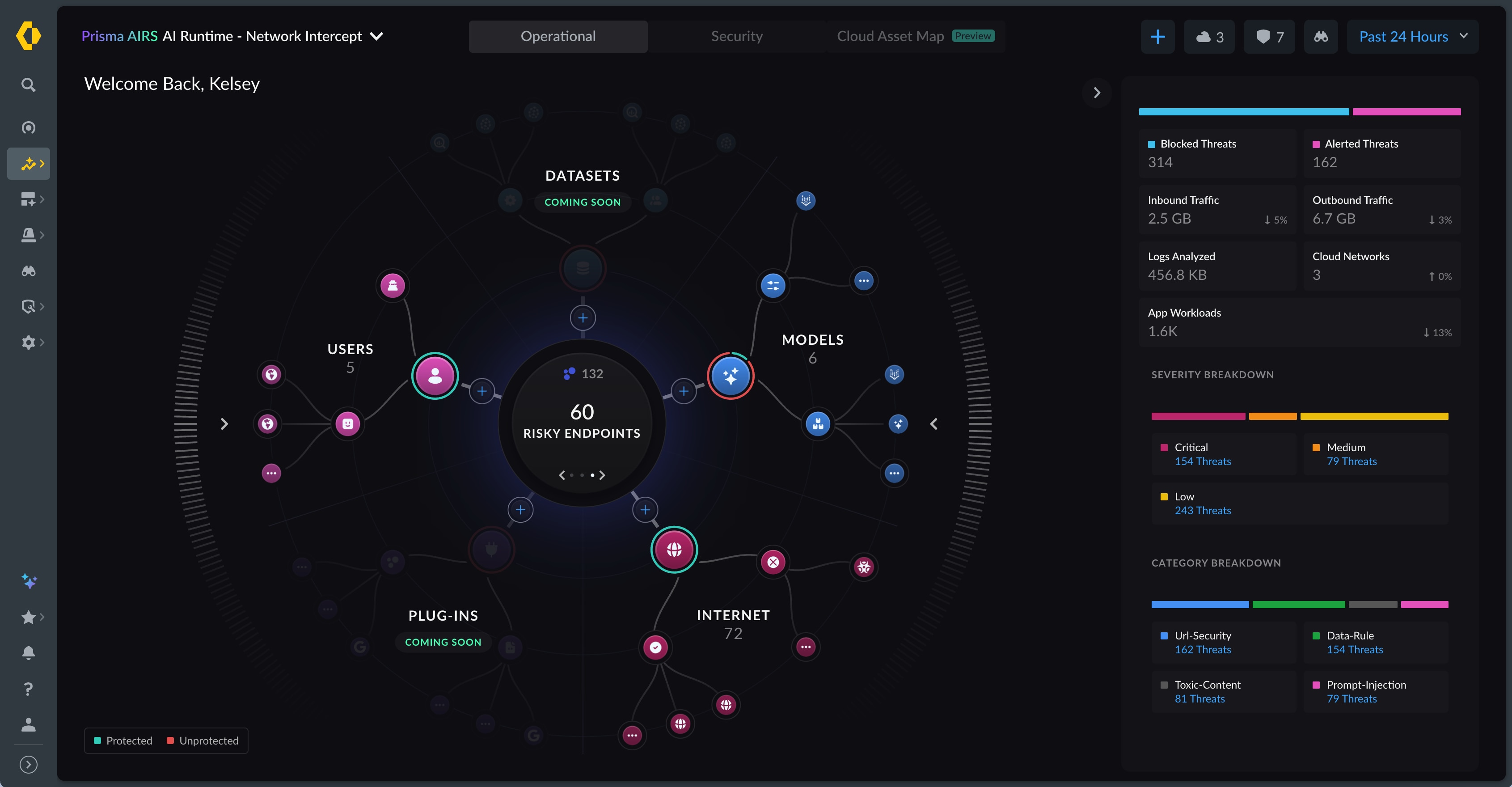

洞察

AI 生态系统

掌握 AI 基础设施、平台及数据的可见性与控制力。

评估

AI 风险

尽早检测漏洞与风险,确保 AI 模型的部署前安全性。

防御

威胁

通过行为监控实时检测异常并阻断在途攻击。

Prisma AIRS 平台保障

从开发到部署全流程中所有应用、智能体、模型及数据

的安全。

AI 模型安全防护

通过漏洞扫描保障第三方 AI 模型安全落地,全面防护模型篡改、恶意脚本及反序列化攻击等风险。

AI 红队测试

先于攻击者发现潜在暴露与潜伏风险。运用红队测试智能体对 AI 应用和模型开展自动化渗透测试,该智能体可对 AI 部署进行压力测试,像真实攻击者一样持续学习并动态调整。

AI 态势管理

获得对 AI 生态系统的全面可视性,预防过度权限、敏感数据暴露、平台配置不当、访问配置不当等问题。

AI 运行时安全

保护 LLM 驱动型 AI 应用、模型与数据,抵御提示注入、恶意代码、有害内容、敏感数据暴露、资源过载、幻觉等运行时威胁。

AI 智能体安全

保护 AI 智能体(包括基于低代码/无代码平台构建的版本),防御身份仿冒、记忆篡改、工具滥用等新型智能体威胁。

最新产品创新

我们正以 AI 的发展节奏加速创新。了解 Prisma AIRS 的新功能与更新。

自动化 AI 红队测试

借助 Prisma AIRS AI 红队测试,模拟真实攻击、发现漏洞,并在多种扫描模式下获取详细风险评分。该功能确保 AI 部署兼具韧性与安全性。

2025 年 10 月

AI 模型安全防护

借助 Prisma AIRS AI 模型安全防护,确保只有安全可信的 AI 模型进入生产。扫描模型以发现漏洞、执行统一安全标准并确保合规。该功能为您 AI 生态系统中的每个模型保驾护航。

2025 年 10 月

MCP 威胁检测

借助 MCP 工具扫描上下文投毒、数据泄露等威胁,保障您的 AI 智能体免受供应链攻击。该功能确保基于 MCP 的 AI 运营安全且可实现自主化。

2025 年 9 月

独立 Prisma AIRS MCP 服务器

通过 Prisma AIRS MCP 服务器部署安全的低代码 AI 防护,它是您扫描与验证 AI 工具交互的集中式网关。该功能简化安全 AI 集成流程。

2025 年 9 月

每个部署配置文件支持多应用

通过在单一安全配置文件下采用统一策略管理多达 20 个应用,简化治理并降低运营开销。这可通过每个部署配置文件支持多应用实现。

2025 年 9 月

统一 AI 安全日志记录

通过将 AI 安全日志与网络事件整合,消除零散可见性问题,为 SOC 提供威胁检测与响应的统一管理界面。这通过 Strata Cloud Manager 中的统一 AI 安全日志记录实现。

2025 年 8 月